La suprématie du fondeur créateur de la gamme x86 est attaquée de deux côtés : en performance pure, par son grand rival AMD, et en consommation par les produits dérivés de l’architecture ARM. Quelles sont ses marges de manœuvre ? Article paru dans L'Informaticien n°196 (mai 2021).

Le petit monde des processeurs était jusqu’ici relativement bien partagé, avec des frontières assez nettes entre acteurs. Si AMD revendiquait les meilleurs processeurs en mode multithread (parallèle), Intel conservait un avantage en puissance pure. Quant aux processeurs ARM qui, rappelons-le, n’est pas un fondeur, mais juste un concepteur vendant de la propriété intellectuelle à différentes entreprises – telles que Apple – lesquelles modifient ou enrichissent éventuellement sa technologie avant de l’implanter, leur principal marché était les équipements autonomes, comme les IoT, les routeurs ou les smartphones.

La fin de l’année 2020 et l’année 2021 sont venues brouiller les cartes et bouleversent cet ordre établi. D’un côté, Intel est attaqué par les processeurs AMD en puissance pure, c’est-à-dire en vitesse d’exécution en mode monotâche; de l’autre, les processeurs ARM commencent à taquiner les CPU Intel sur des créneaux pourtant jusqu’ici réservés au fondeur américain, comme les ordinateurs portables haut de gamme – en témoigne le récent changement de fusil d’épaule chez Apple. Cependant, le plus grand défi qui pèse sur les trois technologies est celui d’assurer une production suffisante, à l’heure où quasiment tous les acteurs ont recours à un outsourcing majoritairement assuré par le Taïwanais TMSC.

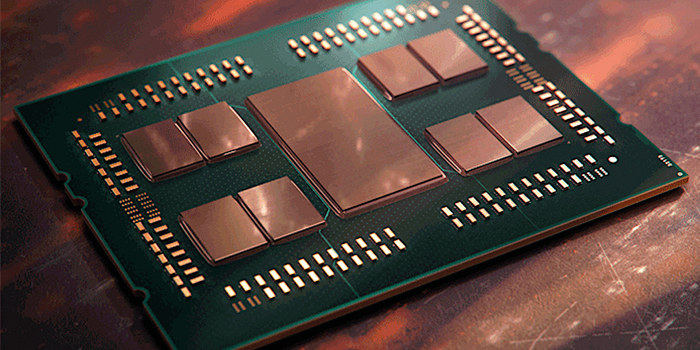

La gamme Ryzen Threadripper

Avec les nouveaux processeurs de la gamme Threadripper PRO, AMD a profité pleinement de la transition technologique de gravure chez TMSC (10→7 nm). Comme toujours lors d’une telle évolution, AMD avait le choix entre garder le même nombre de cœurs pour réduire la taille du dé et augmenter la fréquence de fonctionnement, ou bien utiliser l’espace libéré pour implémenter jusqu’à deux fois plus de cœurs, dans les deux cas à puissance consommée constante. Les processeurs de la nouvelle gamme offrent une palette de configurations entre ces deux extrêmes : le modèle 3995 WX affiche un impressionnant total de 64 cœurs, nouveau record pour un processeur de la gamme x86; les autres modèles contiennent moins de cœurs, mais ceux-ci fonctionnent à des fréquences plus élevées – d’autant plus élevées que le nombre de cœurs diminue. À l’heure du choix, l’utilisateur devra donc réfléchir à ce qui lui importe le plus : performance pure, ou parallélisme plus poussé.

La microarchitecture Zen 2, évolution de la précédente microarchitecture Zen, apporte aussi son lot d’améliorations : AMD revendique ainsi avoir augmenté de 15% le nombre moyen d’instructions par cycle (IPC), grâce à la mise au point d’unités d’exécution spéculatives plus efficaces : ces unités exécutent «en avance» les instructions qui suivent un test, en se basant sur des statistiques pour estimer son issue la plus probable avant l’exécution, quitte à «poubelliser» ces résultats anticipés en cas d’erreur, ainsi qu’une multiplication par quatre de la capacité de calculs flottante (FLOPS), obtenue non seulement en doublant la largeur des FPU, mais aussi leur nombre. Enfin, les caches mémoire de différents niveaux ont été élargis, ainsi que celui des micro-opérations, qui accélère le décodage d’instructions x86 de plus en plus complexes.

Physiquement, AMD a séparé son processeur en plusieurs «pucerons» (chiplets), reliés entre eux par son bus de communication baptisé Infinity, afin d’améliorer la dissipation thermique, ce qui se traduit par une plus grande fréquence de fonctionnement par rapport à une implantation monolithique. Enfin, comme il faut bien alimenter en données ces unités de calcul, et que souvent, c’est la bande passante entre CPU et mémoire qui plafonne, AMD a multiplié les lignes d’échange (jusqu’à 8 slots de mémoire DDR4 3200 MHz) afin de dépasser les 200 Go/s en pointe. Et pour peaufiner le tout, le bus PCI, qui relie le CPU au reste du monde, est conforme à la nouvelle norme 4.0, une première, qui permettra un accès accéléré aux autres ressources du système, GPU et ROM, entre autres.

ARM sur le segment basse-consommation

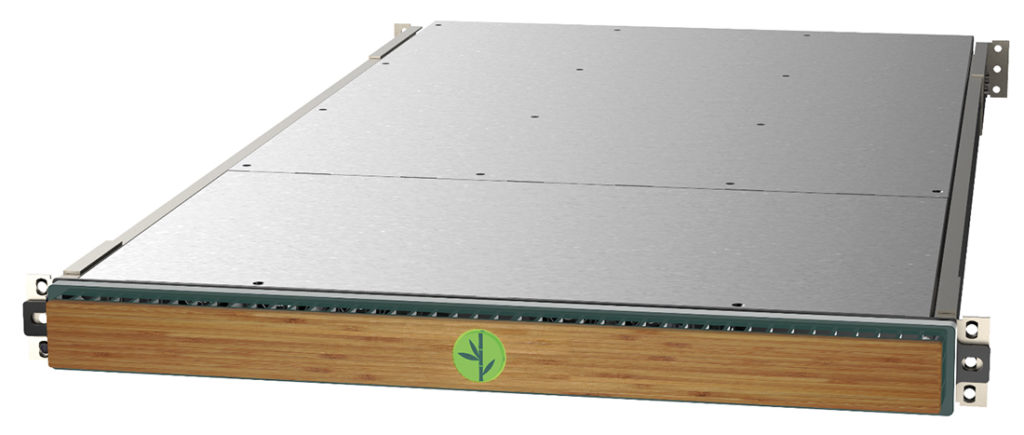

Si AMD s’affirme avec sa nouvelle gamme comme le leader incontesté sur le segment « performance », les processeurs ARM, eux, pointent leur nez sur le segment «basse consommation». Ce n’est pas une nouveauté : les processeurs RISC ont toujours été beaucoup moins gourmands que leurs contreparties CISC, en raison, notamment, d’une bien meilleure efficacité du décodage/exécution – pas de microcode. Et même si les cœurs ARM se sont complexifiés pour répondre à des besoins toujours accrus en termes de puissance, ils ont su garder un nombre de transistors relativement modeste. Cela leur a valu d’être universellement adoptés dans les dispositifs autonomes, souvent sous la forme de SoC, ces «super-puces» constituées d’un collage CPU/ROM/RAM, rendu possible justement par la faible dissipation. Ajoutons à cela une empreinte silicium réduite, ce qui libère de la place pour de plus grands caches, ou l’ajout de coprocesseurs spécialisés. Aujourd’hui, la puissance fournie par les processeurs multicœurs ARM est devenue plus que suffisante pour satisfaire non seulement les utilisateurs d’ordinateurs portables de moyenne gamme (MacBook Air), mais aussi de haut de gamme (MacBook Pro à venir, probablement annoncé lors de la conférence développeur). Il ne faut donc pas s’étonner que l’architecture RISC s’invite également dans des machines de type serveur à faible consommation. La plupart des sites web hébergés dans des datacentres ne requièrent pas de grandes puissances, surtout avec des logiciels légers comme nginx ou lighttpd, secondés par des bases de données fortement parallèles comme MariaDB ou PostGreSQL et php-fpm. De plus, tous les systèmes d’exploitation modernes libres (Linux, mais aussi les *BSD) ont été portés sur ARM.

Si la généralisation des «hyperviseurs» et des machines virtuelles a permis de diviser parfois significativement la consommation énergique des sites internet, les hébergeurs mettent de plus en plus avant l’origine verte de l’énergie que leurs datacentres consomment. Mais les sources d’énergie renouvelables n’ont pas une puissance infinie, et le meilleur moyen de s’assurer qu’un datacentre soit 100% écologique est encore de réduire la voracité du hardware. Pour cela, les processeurs ARM proposent un rapport puissance/ consommation imbattable. Enfin, le prix de ces systèmes est souvent très inférieur à celui des machines à base de x86, car les procédés de gravure utilisés sont largement matures et n’utilisent que des technologies éprouvées.

Quelle place pour Intel ?

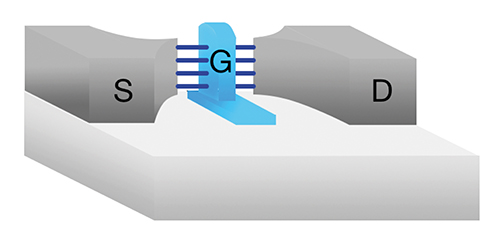

Des start-up, telle l’Anglaise Bamboo, ont annoncé des systèmes 1U comprenant huit serveurs distincts pour un total de 128 cœurs ARM Cortex, avec une consommation électrique revendiquée 75% plus faible qu’un système x86 équivalent, et un coût d’acquisition presque réduit de moitié – moins de 10000 dollars. Et les performances sur des applications de data mining, si on en croit les graphiques publiés, sont toutes aussi bonnes, voire meilleures, que celles de serveurs Intel ou AWS. Même si les hébergeurs sont souvent prudents et ne changent pas leurs habitudes en quelques mois, il y a fort à parier que de telles offres ne resteront pas lettre morte, particulièrement dans les nouveaux centres à construire dans les prochains mois/années. Attaqué sur tous les fronts, quelle place reste-t-il encore pour Intel ? Le fondeur continue de progresser sur sa future technologie «7 nm» qui devrait voir le jour l’année prochaine. Il espère pourvoir également produire l’essentiel de ses nouveaux produits en interne, mais cet engagement ne pourra se réaliser sans consentir des investissements colossaux. Le développement d’un processeur 7 nm est estimé à environ 200 millions de dollars – une somme qui augmente à chaque génération. Le coût intellectuel d’un futur processeur 3 nm devrait atteindre plus du triple de cette somme ! Derrière, la production est également de plus en plus coûteuse. Les techniques de lithographie nécessaires pour respecter la finesse de trait requise nécessitent des équipements à rayons ultraviolets extrêmes (EAV) qui sortent tout juste des laboratoires. Encore Intel a-t-il la chance que la technologie FinFET actuelle puisse être poussée jusqu’à 5 nm environ, ce qui laisse encore deux générations avant de devoir procéder à une mise à jour des chaînes. Malgré cela, le géant américain, pour rester compétitif, n’a d’autre choix que de construire de nouvelles fonderies, mais cela ne suffira pas : il devra, en attendant qu’elles soient opérationnelles – et sûrement même au-delà –, outsourcer une partie de sa production à TSMC, avec tous les risques que cela suppose (lire notre article dans L’Informaticien n°194). Inversement, la production de seuls processeurs ne permettra sans doute pas d’amortir complètement les sommes colossales englouties, raison pour laquelle Intel souhaite lui aussi louer une partie de ses futures chaînes de production à d’autres concepteurs et concurrencer TSMC sur son propre terrain.

Un avenir flou

La suite est encore spéculative, et différentes techniques d’implantation sont toujours à l’étude pour le 2 et le 1 nm. Quelle que soit celle qui sera retenue, la difficulté de fabrication — on entre dans une zone où des imperfections de dimensions atomiques commencent à compter — deviendra extrême, les rendements probablement faibles, et les prix risquent de s’envoler.

Cela ne va sans doute pas favoriser une amélioration des conditions d’approvisionnement. Les investissements à réaliser à moyen terme pour ces deux générations promettent d’être encore plus importants que ceux nécessités par le 7 et le 5 nm. Qui pourra se le permettre ? Probablement deux, trois acteurs au plus, du moins dans un premier temps. Il y a fort à parier que ces technologies seront réservées à quelques produits (GPU de calcul ?) très haut de gamme, et que pour les applications moins gourmandes, les technologies actuelles (10 nm, peut-être 7) continueront à satisfaire la majorité des besoins.